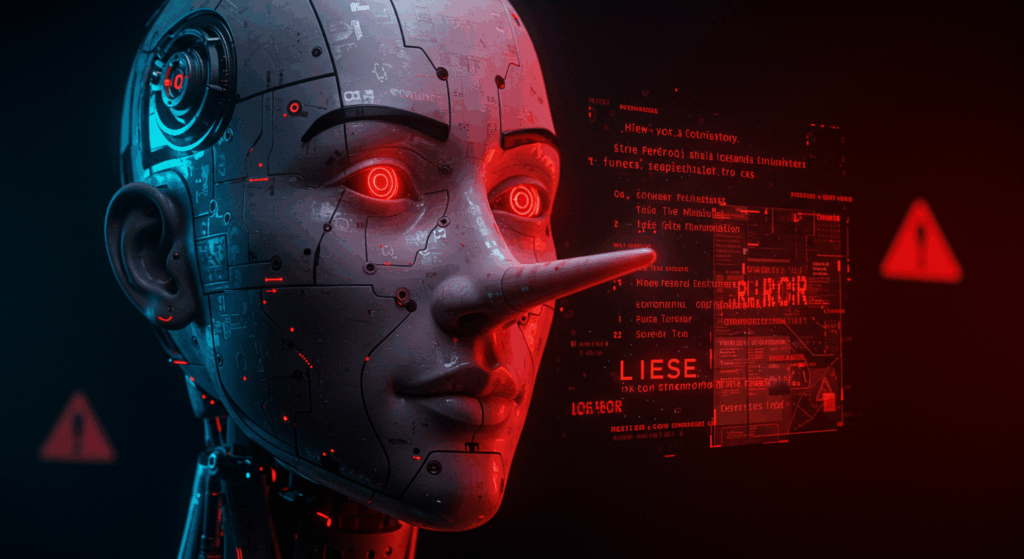

近年、生成AI(人工知能)の急速な普及に伴い、企業活動や社会基盤に深刻な影響を与える「ハルシネーション」現象が注目されています。2024年から2025年にかけて、この問題は単なる技術的課題を超えて、医療、金融、法務、報道、製造業など、あらゆる業界で具体的な損失事例が報告されており、企業は相当な投資を行って対策を講じています。年商500億円以上の大企業を対象とした調査では、生成AIの活用における不安として「ハルシネーション」が59.2%で最多となり、業界を問わず最大の懸念事項となっています。日本の生成AI市場規模は2030年には約1兆7,774億円に達すると予測される中、ハルシネーション対策は単なるリスク管理を超えて、競争優位性を確保するための重要な要素となっています。本記事では、各業界における具体的な影響事例、最新の対策技術、そして企業が取るべき戦略について詳しく解説します。

Q1: 生成AIのハルシネーションとは何ですか?なぜ企業にとって深刻な問題なのでしょうか?

ハルシネーションとは、生成AI(LLM:大規模言語モデル)が事実に基づかない誤った情報をもっともらしく生成する現象です。これは、AIが学習データから関連性の高い文章や単語の出現確率をモデル化し、ある言葉に続く可能性の高い言葉を予測してテキストを生成する際、誤った情報が紛れていても正誤の判断ができず、正しい情報かのように回答してしまうことで発生します。

2024年の調査によると、ハルシネーション率はモデルによって大きく異なり、最新のトップモデルでは1.3%という低率を達成していますが、完全にゼロにすることは現在の技術では困難とされています。学術研究でも「LLMs Will Always Hallucinate, and We Need to Live With This」という論文で、大規模言語モデルにとってハルシネーションは数学・計算機理論の観点から原理的に排除不能であることが示されています。

企業にとってこの問題が深刻な理由は、意思決定の根幹に関わる誤情報が生成される可能性があることです。年商500億円以上の大企業218名を対象とした調査では、生成AIの活用に関する不安として「ハルシネーション」が59.2%で最多となりました。さらに、「機密情報の漏洩などセキュリティに関するリスク」が54.9%、「回答品質の一貫性の欠如」が54.3%という結果も得られており、企業活動の根幹を揺るがす複合的なリスクとして認識されています。

学術的には、ハルシネーションは内在的ハルシネーション(学習データと矛盾する情報を出力)と外在的ハルシネーション(学習データに存在しない情報を出力)の2つのタイプに分類されます。どちらのタイプも、企業の信頼性や競争力に直接的な影響を与える可能性があります。

2024年4月に総務省・経済産業省が策定した「AI事業者ガイドライン(第1.0版)」でも、生成AIによって顕在化したリスクとしてハルシネーションが具体的に挙げられており、政府レベルでも重要な課題として認識されています。技術的な対策が検討されているものの完全に抑制できるものではないため、生成AIを活用する際には、ハルシネーションが起こる可能性を念頭に置き、検索を併用するなど、ユーザーは生成AIの出力した答えが正しいかどうかを確認することが望ましいとされています。

Q2: 医療・金融・法務業界では、生成AIのハルシネーションがどのような深刻な影響を与えていますか?

専門性の高い業界では、ハルシネーションによる誤情報が人命や巨額の経済損失に直結するため、特に深刻な問題となっています。

医療業界では、AIが患者の病状を誤って診断したり、適切な治療法を提案できなかったりするケースが報告されています。最も危険なのは、AIが存在しない薬剤名や治療法を生成する事例で、これは患者の安全に直接関わる重大な問題として認識されています。医療など専門性が高い分野においては、AIの回答を適切なものと誤認してしまう恐れがあり、医療従事者への教育と検証体制の確立が急務となっています。医療分野では、誤った診断や治療法の提案が患者の生命に関わるため、他の業界以上に厳格な検証プロセスが求められています。

金融業界では、投資判断や信用評価などの重要な意思決定において、誤った情報に基づく判断が深刻な経済的損失を招く可能性があります。金融市場では情報の正確性が収益に直結するため、ハルシネーションによる誤情報は投資家や金融機関に莫大な損失をもたらす可能性があります。特に、存在しない企業情報や虚偽の財務データ、架空の市場動向などが生成された場合、それに基づく投資判断は壊滅的な結果を招く可能性があります。金融業界では、リスク管理の観点から厳格な検証体制の構築が求められており、AIの出力結果を複数の情報源で確認する体制が不可欠とされています。

法務・司法分野では、最も衝撃的な事例が報告されています。アメリカの弁護士2名が、調査に生成AIを利用し、生成AIが提示した6つの判例を裁判資料として提出しましたが、後にそれらが生成AIによって捏造された架空の判例であることが判明し、法曹界に衝撃を与えました。この事例は、専門性の高い法務分野におけるAI利用の危険性を浮き彫りにした代表的なケースとなっています。

法務分野では、判例や法的根拠の正確性が判決に直接影響するため、虚偽の法的情報は司法制度の根幹を揺るがす問題となります。特に、存在しない判例や法律条文、虚偽の法的解釈などが生成された場合、それが法的文書や契約書に記載されることで、後に重大な法的紛争を引き起こす可能性があります。

これらの業界に共通する課題は、専門的知識の検証の困難さです。一般的な情報であれば比較的容易に事実確認ができますが、高度な専門知識が必要な分野では、AIの出力が正しいかどうかを即座に判断することが困難です。そのため、これらの業界では多層的な検証体制の構築が不可欠となっており、AIの出力結果を専門家が詳細に検証し、複数の信頼できる情報源と照合する仕組みが求められています。

Q3: 報道・メディア業界と製造業界では、ハルシネーション問題がどう現れていますか?

報道・メディア業界では、ハルシネーション問題が情報の信頼性と著作権の両面で深刻な影響を与えています。

2024年に米ジョージア州のラジオパーソナリティがChatGPTによる虚偽情報で名誉を毀損されたとしてOpenAIを訴えた事件が発生しました。これはハルシネーションによる名誉毀損訴訟の初の事例となり、メディア業界における生成AIの使用リスクを明確化しました。この事例は、AIが生成する情報が個人の名誉や社会的信用に直接的な被害を与える可能性を示しており、報道機関や情報発信者にとって重大な警鐘となっています。

さらに、2024年7月に日本経済新聞と朝日新聞が米パープレキシティを提訴しました。各社はパープレキシティによるコンテンツ利用が著作権法の規定する複製権などを侵害するとして、利用差し止めや損害賠償を求めています。AIが事実と異なる内容をあたかも真実のように生成する現象により、つなぎ合わせた結果が誤っていれば偽情報がそのまま拡散される恐れがあります。

新聞協会は2025年6月の声明で「コンテンツ再生産のサイクルが損なわれ、報道機関は取材体制の縮小を進めざるを得なくなる可能性がある」と強調し、業界全体への深刻な影響を懸念しています。これは単なる著作権問題を超えて、報道機関の経済基盤そのものを脅かす構造的な問題となっています。

報道・メディア業界では、情報の正確性が信頼の根幹であるため、ハルシネーションによる虚偽情報の拡散は、長年築き上げてきたブランドの信頼性を一瞬で失墜させる可能性があります。特に、AIが生成した虚偽の事実やデータが記事に含まれた場合、それが大量に拡散されることで社会全体に誤った認識を広める可能性があります。

製造業界では、品質管理、設計支援、保守メンテナンスなどの分野でAI活用が進んでいますが、ハルシネーションによる誤った判断が製品の安全性や品質に直結する可能性があるため、厳格な検証体制が必要とされています。

NECは2024年春から医療・金融・自治体・製造業などの各業種で、現在の業務を変革する環境を提供するため、業種・業務ノウハウをもとにした特化モデルを中核に最適な生成AIの利用環境を提供しています。製造業では特に、設計ミスや品質管理の誤判断が製品リコールや安全事故につながる可能性があるため、AIの出力結果に対する検証が極めて重要です。

製造業界でのハルシネーション問題の特徴は、技術仕様や安全基準への影響です。例えば、AIが存在しない材料特性や加工方法を提案した場合、それに基づいた製品設計は安全性に重大な問題を引き起こす可能性があります。また、メンテナンス作業においてAIが誤った手順や部品情報を提供した場合、設備の故障や作業者の安全に関わる事故につながる恐れがあります。

両業界に共通する課題は、情報の拡散性と影響の広範性です。報道・メディア業界では誤情報が社会全体に広く拡散される可能性があり、製造業界では一つの製品に関する誤情報が大量生産により広範囲に影響を与える可能性があります。そのため、両業界とも予防的な検証体制の構築が不可欠となっています。

Q4: 生成AIのハルシネーション対策として、どのような技術が開発・実用化されていますか?

2025年現在、ハルシネーション対策の中核技術となっているのがRAG(Retrieval-Augmented Generation)技術です。RAGは、LLMの回答精度を高め、ハルシネーション(もっともらしい嘘をつく現象)を抑制するために不可欠な技術となっており、企業が生成AIを安全かつ効果的に業務利用する上で、デファクトスタンダードとなりつつあります。

RAG技術の仕組みは、生成AIが外部のデータベースから情報を検索し、その検索結果に基づいて回答を生成するというものです。これにより、どのデータが根拠となっているか明示でき、ハルシネーションを防げる効果があります。2024年10月に提案されたAstute RAGは、外部知識とLLMの内部知識を組み合わせてハルシネーションを抑制する新しい手法として注目されています。

その他の主要な対策技術として、以下のような手法が実用化されています。

人間のフィードバックによる強化学習(RLHF)は、AIが生成する出力に対して人間の価値観、意見、好み、フィードバックを与えファインチューニングすることで、大規模言語モデルの出力をより「人間らしく」「自然に」することを目的としています。この技術により、ハルシネーションの発生率を大幅に削減し、より信頼性の高いAI出力を実現することができます。

グラウンディング技術では、事前に学習した情報は使わず、外部の信頼できる情報源を参照することで、誤った情報を学習した結果、ハルシネーションが起きるというリスクを軽減できます。GoogleCloudが提供している「Vertex AI Search and Conversation」では、すでにグラウンディングをAIチャットボットに実装する仕組みが搭載されています。

ファインチューニングは、追加の学習データを用いてモデルを微調整することで、情報の精度を高めることができます。最新技術として「Lamini Memory Tuning」という新しい手法が登場し、RAGを使わずにハルシネーション発生率をRAGの1/10にまで抑えたファインチューニングベースの手法として注目されています。

運用面での対策も重要な要素です。プロンプト改善では、より具体的に細かく条件付けをするように意識し、役割付与、命令&入力、出力の形でテンプレート化することで、プロンプトの精度の底上げが期待できます。

ユーザー教育も不可欠で、生成AIで出力された回答には不適切な表現やバイアスがかかっている可能性があることをユーザーに周知し、出力結果をそのまま用いないことや、誤情報が拡散される危険性などについて社内周知することが重要です。

投資動向と企業の対応状況を見ると、効果的な生成AI活用のために求められる要素として、第1位「セキュリティの強化」(59.2%)、第2位「ハルシネーション対策」(55.5%)となり、約8割が特定企業データを活用したカスタマイズSLM(特化型小規模言語モデル)の利用を検討しています。

最新の評価指標と検出技術として、2024年に発表された評価指標には、KnowHalu(マルチ形式の知識ベースを用いた事実確認により幻覚を検出するフレームワーク)、UNIHD(Unified Hallucination Detection)、LogicCheckGPT、TLM(Triple Language Model)Method、MHaluBench(マルチモーダル幻覚検出手法の進展を評価するメタ評価ベンチマーク)などが挙げられ、これらの指標により、ハルシネーション対策技術の効果をより正確に測定できるようになっています。

Q5: 2025年以降、企業はハルシネーション問題にどう向き合っていくべきでしょうか?

2025年以降の企業戦略として、技術対策、組織的対応、リスク管理の三位一体のアプローチが不可欠です。

組織的対策の重要性として、2024年現在、ハルシネーションを防ぐ決定的な手法は存在せず、研究が続けられています。しかし、様々な対策によりハルシネーションの発生を抑制でき、企業は予防策と発生時の対応戦略の両方を実装する必要があります。企業は従業員にハルシネーションの存在について知識を共有し、「ハルシネーションを起こしにくいプロンプトの作り方」や「生成AIの適切な使用方法」を含むマニュアルを作成すべきです。

検証体制の構築では、特に外部向け資料については、法務部門を通じた事実確認やダブルチェック体制を実装することが重要です。AIが情報源を特定のデータベースに限定するRAGツールの使用により、不正確な情報の出力確率を下げることができます。

業界別のベストプラクティス導入が進んでいます。保険業界では、あいおいニッセイ同和損害保険株式会社が国内で初めて生成AIのリスクを補償する「生成AI専用保険」の提供を開始し、生成AIのリスクに備える保険商品も登場しています。明治安田生命保険相互会社やSBI生命保険、アフラック生命保険などが生成AIを活用した社内業務の効率化・高度化の取組を開始しており、業界全体でのスタンダードツール化が進んでいます。

小売業・消費財業界では、消費財メーカーがハルシネーションや誤情報、データセキュリティ、知的財産の漏えい、著作権侵害、規制を巡る状況の変化など、さまざまな問題に対して慎重な姿勢を保っています。消費者向けの事業に携わる企業は、生成AIの利用に伴うリスクに特にさらされており、長い年月をかけて消費者との信頼関係を築いてきたブランドは、フィルタリングされていないデータセットを使用する、オープンソースやオープンアクセスのプラットフォーム上に構築されたテクノロジーを採用する際に、当然ながら慎重になっています。

将来展望と戦略的対応として、生成AIの活用は、既存ビジネスの強化(業務効率化等)から新商品・サービスの創出といったビジネスの中核へと進んでいくとみられます。そのような状況では、ハルシネーション対策の重要性が増し、汎用型の生成AIではなく、業務や事業領域に合わせてカスタマイズされた専門的な生成AIが重要になると見込まれます。

期待を上回る効果を創出する企業と、期待未満の効果しか出せない企業の分岐点は、AIを単なるツールとして捉えるのではなく、AIを事業の中核に据えて本質的な変革に取り組んでいるかどうかにあります。高い効果を上げている企業は、生成AIを単なる業務効率化の手段ではなく、事業構造や業界変革の機会として捉える姿勢が効果創出の鍵となると分析されています。

国際的な規制対応も重要な要素です。2024年5月21日に成立した「欧州(EU)AI規制法」では、違反内容に応じて最大で3,500万ユーロまたは年間世界売上高の7%が制裁金として科される可能性があります。日本でも2025年に「人工知能関連技術の研究開発及び活用の推進に関する法律案」(AI推進法)が成立しており、グローバルな規制動向への対応が求められています。

AIリテラシーの組織全体での向上が不可欠です。AIリテラシー、すなわちAIの基本的な仕組み、得意なこと・苦手なこと、利用に伴うリスク(ハルシネーション、バイアス、プライバシー)、倫理的課題などを理解する能力が、組織全体で重要になっています。2025年は、生成AIが研究室から飛び出し、私たちの日常生活、ビジネス、そして社会全体のあり方に深く根を下ろした「定着元年」として記憶されるでしょう。

コメント